奨励研究に応募してみました。

日本学術振興会 科学研究費助成事業の奨励研究に応募してみました。テーマはSci-Hubです。奨励研究は、Webサイトにある以下の記述のとおり、科研費番号を持たない事務職員でも応募可能な科研費です。

日本学術振興会 科学研究費助成事業 奨励研究

https://www.jsps.go.jp/j-grantsinaid/11_shourei/index.html

奨励研究は、教育・研究機関の教職員等であって、他の科学研究費助成事業の応募資格を持たない者が一人で行う教育的・社会的意義を有する研究を助成し、奨励することを目的とするものです。

研究の対象は、人文学、社会科学及び自然科学の全分野の研究で、教育現場等での実務に基づく研究等を対象とします。

ただし、商品・役務の開発・販売等を直接の目的とする研究(市場動向調査を含む。)及び業として行う受託研究は除きます。

単独かつ単年の研究で、上限は100万円です。

科研費データによると2017年は4065件の応募に対して、採択は732件、採択率は18.1%です。

https://www.jsps.go.jp/j-grantsinaid/27_kdata/index.html

今年は9月1日に公募の通知があり、11月7日が締めきりでした。申請は科研費の電子申請システムを利用します。11月7日締めきりといっても、その前に2つの学内締めきりが設けられていたので、結構手続き慌ただしかったです。10月初めには書類を準備して提出していました。

前のブログ記事のとおり2月から8月くらいまで、Sci-Hubのログ分析を行っていました。6月くらいにはいくつか今回掲載された「情報の科学と技術」には盛り込めないネタも出てきており、継続的に調査しても面白いなぁと考えていました。科研費の奨励研究の申請は、同僚も申請してたりで数年前から気になっていました。

今年度の大学図書館系の採択はざっと検索した限りでは1件でしょうか。

手続き

手続きとして必要だったのは、以下のことです。

- 所属機関の実施資格確認申請

- 研究倫理のe-Learning受講

- JSPS

- 所属機関独自

- 申請書

- URAの個別面談(×2回)

- 外部資金担当の事務チェック

申請書提出にあたってURAや科研費事務担当にチェックして貰えたのはありがたかったです。また、URAの方とオープンサイエンスなどの話をする切っ掛けにもなりました。

申請書類

全部で5ページです。以下の項目各A4で1ページでした。

1. 基本事項(所属・審査区分・研究課題名等)

2. 研究目的・方法など

3. これまでの研究活動及びその成果

4. 研究経費、使用内訳

5. 人権保護及び法令等の遵守への対応

5ページ目は、アンケート調査など行うときには必要ですが、私は予定していなかったので実質3ページ程度でした。研究目的・方法が1ページしかないので、ざっくりとしか書けず他分野の研究者が審査することを考えるとかなり内容の絞り込みが必要だと感じました。経費は旅費と物品がメインです。

おわりに

e-Learningや申請にあたっての諸手続があったり、申請できる期間が短いとはいえ、申請書そのもののボリュームはあっさりしているんだなという印象です(採択された後が本番ですが…)。採択されるかは分かりませんが、外部資金申請の手続きが少し分かったのは良かったです。採択されても、されなくても結果は来年このエントリに追記します。通ったら本家のCode4Libで発表するのを目標にがんばります。

新聞沙汰になったことなど

タイトルは思いつかず…。まさか大谷翔平ではなく、自分の名前を全国紙の一面で見つける日が来るとは思いませんでした…。というわけで記事公開のお知らせと記録のために、1年1ヶ月ぶりの投稿です。

以下の記事をあの坂東慶太さんとの共著で執筆しました。

大谷 周平, 坂東 慶太, 論文海賊サイトSci-Hubを巡る動向と日本における利用実態. 情報の科学と技術. 2018, 68 巻, 10 号, p. 513-519, https://doi.org/10.18919/jkg.68.10_513.

この号は、特集主査が昔からの友人ということやテーマがオープンサイエンスという偶然の面白さを感じるものでした。こんなコメントも。

おお、奇しくもオープンサイエンス特集の号にハゲタカOAとブラックOA(Sci-Hub)の話が載ることになっているとは / “論文海賊サイトSci-Hubを巡る動向と日…” https://t.co/6mUhdjonAP #science #university #エレクトリック

— min2fly (@min2fly) 2018年10月2日

投稿記事はオープンアクセスになっていますので、ぜひご覧いただければ幸いです。

Altmetric Attention Scoreはこちら。

https://www.altmetric.com/details/49067679?fbclid=IwAR0DHd0ivKx4pT3m6COm5Eu0_3HUhS0e0MFeWxX_0rarhYnU-ztTO-eSf34

2018年1月にEBSCOさんのAcademic Advisory Board Meetingで香港にお招きいただいたときに、日本からの参加者ということでご一緒したのが執筆の切っ掛けです。滞在中、学術情報流通に関連するトピック、MendeleyやORCIDなどについていろいろ教えていただいたのですが、その際にSci-Hubも話題となりました。Sci-Hubのことは当然知っていましたが、ログデータが公開されていることや、栗山先生が日本からの利用状況を報告されていることなどは、その時初めて知りました。

絶対に公開できない情報ですが、所属機関で何が利用されているのか、どれくらい利用されているのか、把握できるならしておきたいなというのが、私の関心のスタート地点でした。幸か不幸か、Sci-Hubのログデータには利用者の所属機関を明らかに出来るような情報は含まれていませんでしたが。

執筆にあたって印象に残っているのは、日本からの利用の20%をOA文献が占めているといること、分析プログラム(研究データ)の整理が上手く出来なかったことです。オープンアクセス・オープンサイエンスに関わっている以上、やらねばと考えていたのですが、上手くできたとは言いがたい結果になってしまいました…。

記事公開後に朝日新聞の野中記者からコンタクトいただき、11月12日にWebで公開された記事になりました。

有料論文に海賊版サイト 国内の不正入手、127万件:朝日新聞デジタル

有料記事のため本文は読めず、「琉球大学などの解析」とあるので名前出てるかもなぁくらいに軽く考えていましたが、まさかの全国紙一面でした…。((沖縄は新聞購読のほとんどを地元2紙が占めており、全国紙で朝読めるのは日経だけです。この日も紙の朝日新聞は午後まで手に入らず、聞蔵にお世話になりました。))

大阪版が一番扱いが大きく、1面・3面の記事です。他の地方では1面に圧縮した記事とのことでした。

大阪版3面にあたる記事

研究者を誘惑する論文海賊版 高騰する購読料、大学圧迫:朝日新聞デジタル

会員登録すれば読める無料記事

論文、「海賊版」から入手横行 本来は有料、国内127万件ダウンロード:朝日新聞デジタル

さすがに影響力が大きく、掲載されたその日のうちに全国紙1紙と地元紙2紙からコメントを求められ、大学の広報部署とやりとりしながら対応することになりました。うち1紙はすでに有料記事として掲載されています。(ペイウォール…)

有料論文を無料でダウンロード 海賊版が横行、琉球大など解析 | 沖縄タイムス+プラス プレミアム | 沖縄タイムス+プラス

毎日新聞のハゲタカジャーナルのように、学術情報流通の課題が広く認知される切っ掛けとなりそうで、記事にしていただきありがたいです。しかし、今回初めて新聞で取り上げていただいて、新聞記事にDOI(に限らず典拠情報)がもっと記載されるべきと感じました。紙面の都合で難しければWeb版だけでも。朝日新聞でも以下のような前例は既にあるんですね。

今世紀末、ビール価格2倍に? 異常気象で大麦に異変:朝日新聞デジタル

スウェーデンでSci-HubをブロックをしたISPがエルゼビア公式もブロックしたり、SPARC Japan セミナー2018「オープンアクセスへのロードマップ: The Road to OA2020」でもSci-Hubに関する言及がと、記事執筆後の動きもあります。また、既存データでも私の技術力などの問題で分析しきれなかったネタがあるので、スキルを上げつつ、また、続報を書きたいです。

- Swedish ISP punishes Elsevier for forcing it to block Sci-Hub by also blocking Elsevier / Boing Boing

- 国際学術情報流通基盤整備事業 │ イベント情報 │ 2018 │ 2018年度第3回「オープンアクセスへのロードマップ: The Road to OA2020」

最後になりましたが、海賊サイトの利用分析という悩ましいテーマにもかかわらず掲載に踏み切ってくださった、南山さんをはじめとする、「情報の科学と技術」編集委員会のみなさま、いつも的確なコメントでクオリティをあげてくれた林さん、データ集計の部分で基本的なことからきちんと指摘いただいた査読者の方(上手くコメント活かせなくて申し訳ありません…)、半年に渡り全体構想から分析のアドバイス、投稿関係の諸作業、投稿後のアウトリーチ活動とお世話になりっぱなしの坂東さん、本当にありがとうございました!*1

*1:ファーストオーサーということで、各紙私の名前が出てしまいましたが、坂東さんの貢献の方がはるかに大きく、絶対に私1人では形にできませんでした。本当にありがとうございます。

パスワードで保護されたPDFをメタデータからリネーム(Mac)

10/6 追記

id:kitoneに教えてもらった方法です。

qiita.com

自分の環境では未検証ですが、確かにこれでいけそう。

- -

自分用のメモです。もっとスマートなやり方あったら誰か教えていただけると嬉しいです。

やりたいこと

日経BP記事検索サービス*1からダウンロードしたPDFファイルをそれぞれのPDFのメタデータ情報から一括でリネームする。

ダウンロードした時のファイル名です。ファイル名を見ても内容が分かりません。

それぞれPDFにはきちんとメタデータが埋め込まれています。メタデータのタイトルと作成者からを利用してPDFファイルをリネームすることです。

作業手順

スクリプト

import os files = os.listdir('./')#現在のフォルダに含まれているファイル名一覧を取得 file_name={} with open ("****.txt") as f:#Automatorで出力したファイルを指定 for i,v in enumerate(f.readlines()):#行数とファイル名を出力 x=i%3 if x== 0: key=v.strip()#現在のファイル名をキーに elif x==1: try: value=v.strip().split('\t')[0]+"_"+v.strip().split('\t')[1].replace("日経BP社 ","")#メタデータから抽出したタイトルと作成者情報を値に。 except: pass#データ区切りの改行はスキップ else: file_name[key]=value for i in files:#現在のフォルダにあるファイル一覧をループで全件処理 try: os.rename('./'+i,'./'+file_name[i]+'.pdf')#現行ファイル名をもとに、ファイル名を値に変更 except: pass#変換対象ではないデータの場合はスキップ

実行結果

琉大図書館用のChrome拡張を作りました

Extension for Univ. Ryukyus LibraryというChrome拡張機能を作成しました。業務用に作った物ですが、Chrome Webストアで公開しています。

機能は以下の5つです。

- 文字列を選択した状態で右クリックのコンテキストメニューを開くとワンクリックで琉大のOPAC、沖縄文献情報データベース、CiNii Books、CiNii Articlesの検索が出来ます。

- Amazon・honto・丸善Knowledge Worker・沖縄県立図書館の図書詳細画面で琉球大学の蔵書を確認出来ます。Knowledge Workerでは検索結果一覧画面でも機能します。(ISBNのある本限定、カーリルAPIを利用。)

- PubMed検索結果画面で、PMIDにリンクリゾルバへのリンクを付与します。

- CiNii Articlesの詳細画面で、掲載雑誌の沖縄県内所蔵館を表示。(CiNii Books APIを利用)。

- 新規タブを開くと琉大図書館の写真がランダムで表示。

この機能を順番に操作しているだけの動画です。

Extension for Univ. Ryukyus Libraryの機能説明

作成動機など

そもそもは職場で構築している沖縄文献情報データベース*1をもっと使いやすくできないかというものでした。論題をMecabを使って単語に分割し、頻出単語を中心にWordCloudを作ってみたりしてました。

BIDOM Wordcloud

その一環として、コンテキストメニューからBIDOMを検索できると便利かなと思って拡張機能を作ってみました。拡張機能開発は想像していたよりも手軽にできたので、他にも幾つか自分が欲しかった機能を実装してみたものです。

例えばAmazonでカーリルAPIを使って、図書館の所蔵情報を表示するような拡張機能は幾つかあります。

Libron - Chrome Web Store

その本、図書館にあります。 - Chrome Web Store

しかし、私がよく使うhontoに対応した拡張機能は知りませんでした。他にも職場の選書では丸善のKnowledge Workerを利用したりします。*2また、沖縄県立図書館は沖縄関係資料ではかなり細かく目次情報を入力しています。そのため、人文系の研究をしている同僚から沖縄県立図書館OPACで資料を探した後に職場のOPACで所蔵をチェックするといった話を聞いていたので、県立図書館のOPACにも対応してみました。*3

今後について

リファクタリングできたらソースも公開します。現状は電子書籍の契約状況には対応していないので選書ツールとして使うためにも、OPACに登録している電子書籍の状況は把握できるようにしたいです。

他にはページ中のDOIをもとにリンクリゾルバとoaDOIの結果を表示する機能とか作れると便利かなと考えています。

cheb.hatenablog.com

chrome.google.com

chrome.google.com

参考にした記事

qiita.com

qiita.com

stackoverflow.com

id:haseharuさんの2つの拡張機能も大分コードを参考にさせて貰いました。

haseharu.hatenablog.com

chrome.google.com

最後になりますが、API提供機関(カーリル・NII)のみなさま、どうもありがとうございます。

韓国の大学図書館で何が話題になっているのか? 2017年版

開催から大分経っていますが、今年も。

2017年6月22日-23日。청주で開催されています。

公式サイトは以下。

2018 전국대학 도서관 대회에 오신것을 환영합니다.

分科会は去年まで相互貸借とレファレンス・閲覧は2つのグループでしたが、ここはひとまとめになって図書館マーケティングが新設されてますね。

全体会

- 基調講演1:4次産業時代に文化とは?

- 基調講演2:4次産業革命の時代、もう一度考えてみる知識の本質と価値

実務グループ分科会

収書

- 2017年電子情報コンソーシアム事業計画と進捗

- 【海外事例】主題専門司書vs機能専門司書

- 【討議】大学図書館の評価による単行本と電子情報資源収書案について

相互貸借・レファレンス・閲覧

- 1人メディア放送を活用した利用者教育

- 4次産業革命と図書館空間

- 【討議】卒業生、休学生、修了生などの特別な利用者に対する図書館サービス提供ポリシー

図書館マーケティング

電算

2日目はHathiTrust についてミシガン大学の方を招いて講演など行われていました。

気になるのは仕事柄、電算の分科会ですが残念ながら分科会の資料は公開されていなかったので、詳細は不明です。

浦項工科大学と大邱慶北科学技術院の事例です。

浦項工科大学のリポジトリ。Dspace。Scopusの被引用数情報を表示など。

OASIS Repository @POSTECHLIBRARY: Home

大邱慶北科学技術院のデジタルキュレーションサービス。

Digital Curation System

WoSやScopusを利用して、所属研究者の論文をお知らせしているみたいですね。

過去記事

参加メモ:泉川図書館長が教えてくれる ふるさと発見!読谷を知ろう(講座)

イベントカレンダー:泉川図書館長が教えてくれる ふるさと発見!読谷を知ろう(講座) - 読谷村

読谷に住み始めて実質3年くらいですが、あまり村の歴史などについてしらないなぁと思っていたところ、読谷村立図書館でイベントが開催されていたので参加してきました。職場が一斉休業の日というのもちょうど良かったです。夏休み企画でしたが、親子連れだけでなく、村の職員さんなんかも一般参加されていました。

スケジュール

講師の泉川館長は村史編纂室で長く勤務され、退職後に村立図書館の館長をされています。この企画も泉川さんが館長になって始められたものだそうです。以前から村の新採用職員向けに村の歴史講話やバス巡検をされていたそうです。この辺の執筆にも一部関わられているとか。

- 作者: 安里進,田名真之,豊見山和行,西里喜行,高良倉吉

- 出版社/メーカー: 山川出版社

- 発売日: 2010/11/01

- メディア: 単行本

- この商品を含むブログを見る

面白かったポイントは

- 村役場は当時基地の真ん中だったが、村民中心の町作りをするという意思表示もこめて村の中心に作った。

- 風水も意識している。(講話では触れませんでしたが、韓国に風水の勉強にいった職員の方もいるそうです)

- 基地の真ん中で民間バスも走っていないので、コミュニティバスを運行した。

- 比嘉秀平・屋良朝苗という戦後沖縄の政治家の出生地。

- 比嘉秀平に関しては、本人が家族に累が及ぶことを恐れて資料を燃やしており、ほとんど資料が残っていない。

- 赤犬子(あかいんこ)って人名だったんだ。赤犬子(あかいんこ) - 読谷村楚辺公民館

- 沖縄本島北部と中南部で土壌が違い、焼き物に使われるのはもっぱら北部の土

鳳計画、読谷を鳳に見立てています。中央の従事箇所に役場が。図書館や文書館などの複合施設計画があり4〜5年後のオープンを目指しているということで楽しみです。

やちむんの里の登り窯、13連で稼働している中では国内最長ではということでした。

やちむんの里のブーゲンビレア。村花。村魚は先日ジンベイザメに決まりました。

屋良朝苗像。左右の人と腕を組むポーズだそうです。

古堅国民学校跡。側に生えているデイゴは沖縄名木100選に。

村史編纂室が作成した、各字毎のガイドブック。まだ全字分完成していないですが、そろった際には是非書籍化して欲しい。

普段の通勤経路にもいろいろ発見があり、大変楽しむことが出来ました。

泉川館長、村立図書館のみなさまありがとうございました。

自機関の研究者はどのジャーナルから論文を引用しているのか?

この記事ではWeb of Scienceから出力したデータを用いて、研究者が投稿した論文で引用したジャーナル情報を抽出する方法を紹介します。

大学は学術雑誌に多大な投資をしていますが、研究者が利用するジャーナルを適切に提供できているのかを知ることが目的です。(残念ながらこの記事ではそこまで調査できていません。)関係する研究としては以下の2つがあります。(id:nacomintさんありがとうございました!)

- 気谷陽子, 歳森敦. 学術図書館における学術文献の供給可能率に関する研究. 情報の科学と技術. 2002, vol. 52, no. 9, p. 477–483. http://ci.nii.ac.jp/naid/110002829096/, (参照 2017-02-01).

- Ishita, Emi, Watanabe, Yukiko, Yamaguchi, Ai, Oda, Takako, Higa, Yuiko, Horiuchi, Miki, Mitani, Naoya. The Ratio of Conference Papers in Citations of Engineering Dissertations at Kyushu University. Springer Berlin Heidelberg, 2012, p. 59–62. http://link.springer.com/10.1007/978-3-642-34752-8_7, (参照 2017-2-01).

Web of Scienceから分析対象のデータをテキスト形式でダウンロード、簡単なテキスト処理を行ってデータを構造化、分析という流れです。分析にはPythonを利用しています。

手順

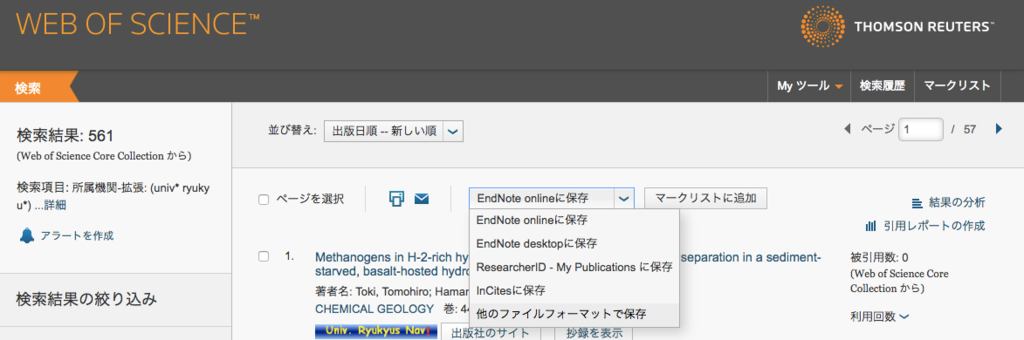

- Web of Scienceにアクセスして、検索フィールド「所属機関-拡張」で「univ* ryukyu*」を検索。検索期間は2016年に。

- 検索結果一覧画面で「他のファイルフォーマットで保存」を選択。

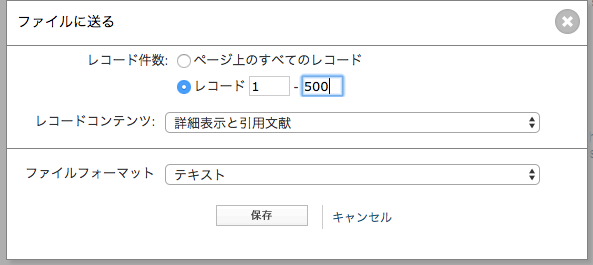

- 最大500件まで出力できるのでレコード番号を指定、「詳細情報と引用文献」「テキスト」を選択して出力。

- 必要なデータを全て出力するまで、3.を繰り返す。

- Pythonでデータ処理(利用したコードは後述)。

出力したテキストデータには以下のような引用文献のデータが含まれています。Web of Scienceに採録されていないジャーナルなどからの引用も出力されているようです。

CR Butterfield DA, 1997, PHILOS T R SOC A, V355, P369, DOI 10.1098/rsta.1997.0013

Charlou JL, 2000, CHEM GEOL, V171, P49, DOI 10.1016/S0009-2541(00)00244-8

Coplen TB, 2002, PURE APPL CHEM, V74, P1987, DOI 10.1351/pac200274101987

ほかにもアブストラクトやDOI、投稿したジャーナルの出版社などの情報も取得できます。

単なるテキストデータですが、各項目の見出しが行頭に、要素の繰り返す場合は行頭が空白文字列という規則的な構成になっているので、比較的簡単にデータを構造化することができます。ただし、引用文献のデータそのものは1行1レコードの文字列に過ぎないので、さらに加工が必要です。前述のデータはカンマ区切りで著者,刊行年,ジャーナル名,巻号,DOIとなっていて扱いやすいのですが、書籍やWebサイトからの引用や巻号の構造などの要因でレコードの要素数が一定ではありません。今回はある程度割り切ってカンマで分割し、そのうちの3番目の要素をジャーナル名とみなしました。というわけで以下のすべての結果は、大まかな傾向は示しているはずですが、完全に正確なデータという訳ではありません。

結果

2016年に琉球大学の研究者が共著も含めて執筆に関わった論文数は561(2017年3月1日現在)、その論文のなかで引用されている資料数は20737。

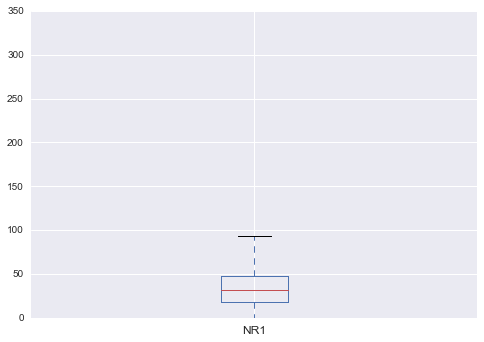

論文単位の最小引用数は0、最大引用数は320、平均36.97、320の文献を引用しているのはWoSの分類でZoologyの原著論文([doi: 10.3897/zookeys.641.10346])でした。Pythonの機能を使って、箱ひげ図でプロットすると、320件の引用しているものは外れ値扱いされています。

論文のなかで引用されていたジャーナルのTOP20とその引用数は以下の表のとおりです。

| ジャーナル名 | 引用数 | |

|---|---|---|

| 1 | NATURE | 268 |

| 2 | P NATL ACAD SCI USA | 247 |

| 3 | PLOS ONE | 225 |

| 4 | SCIENCE | 219 |

| 5 | PHYS REV B | 181 |

| 6 | J PHYS SOC JPN | 158 |

| 7 | J BIOL CHEM | 137 |

| 8 | CORAL REEFS | 129 |

| 9 | PHYS REV LETT | 117 |

| 10 | NEW ENGL J MED | 106 |

| 11 | MOL BIOL EVOL | 101 |

| 12 | BLOOD | 98 |

| 13 | NAT GENET | 97 |

| 14 | PHYS REV D | 97 |

| 15 | J IMMUNOL | 91 |

| 16 | LANCET | 88 |

| 17 | BIOINFORMATICS | 83 |

| 18 | J AM CHEM SOC | 82 |

| 19 | ZOOL SCI | 82 |

| 20 | MAR BIOL | 81 |

ジャーナル名称は省略形でしか出力されませんが、上位20位だとさすがに有名どころが多いですね。

Coral ReefsやMarine Biologyあたりは、自機関の特徴を表していそうです。

ただし、上位20タイトルでは引用されている資料数20737の13%程度しかカバーできず、80%までカバーするには2150タイトル必要という結果になりました。PLOS ONEが3番目に引用されているようにOAジャーナルも一定程度含まれているとは思いますが、ビッグディールの恩恵が多分にありそうです。

大学図書館でどの程度文献が提供できているか、どのジャーナルパッケージがよく利用されているか、どの程度OAの文献が引用されているかなどを明らかにするのが次の目標です。雑誌の省略形>ISSN>リンクリゾルバAPIという流れでジャーナルの詳細を調べる、もしくはDOIが含まれているレコードに限定して調査すれば実現できそうです。

以下、いくつかこんなデータも出してみました。

引用文献の出版年

| 出版年 | 件数 |

|---|---|

| 2016 | 255 |

| 2015 | 982 |

| 2014 | 1283 |

| 2013 | 1325 |

| 2012 | 1287 |

| 2011 | 1189 |

| 2010 | 1088 |

| 2009 | 1055 |

| 2008 | 985 |

| 2007 | 891 |

| 2006 | 836 |

| 2005 | 805 |

| 2004 | 728 |

| 2003 | 632 |

| 2002 | 521 |

| 2001 | 504 |

| 2000 | 542 |

| 1999 | 462 |

| 1998 | 384 |

| 1997 | 339 |

| 1996 | 312 |

2012から2014に書かれた論文が最も引用されており、それ以前の論文は徐々に件数を減らしています。一方で1500年代から1700年代の文献の引用も確認されました。分野によってどの程度過去の文献を参照するかは傾向があるはずなのでそれを確認することや、OAになっている資料の比率なんかを調べても面白いかもしれません。2,3の論文を見た範囲ですがZoologyのなかでも分類に関連した研究は1800年代の研究もよく参照しており、

Biodiversity Heritage Libraryのお陰で利用できるという資料も多かったです。

投稿しているジャーナルの出版社

| 出版社 | 件数 | |

|---|---|---|

| 1 | WILEY-BLACKWELL | 51 |

| 2 | SPRINGER | 30 |

| 3 | ELSEVIER SCIENCE BV | 24 |

| 4 | PUBLIC LIBRARY SCIENCE | 21 |

| 5 | PERGAMON-ELSEVIER SCIENCE LTD | 19 |

| 6 | BIOMED CENTRAL LTD | 17 |

| 7 | PHYSICAL SOC JAPAN | 15 |

| 8 | NATURE PUBLISHING GROUP | 13 |

| 9 | SPRINGER JAPAN KK | 13 |

| 10 | ELSEVIER SCI LTD | 12 |

| 11 | LIPPINCOTT WILLIAMS & WILKINS | 11 |

| 12 | SPRINGER HEIDELBERG | 11 |

| 13 | ACADEMIC PRESS INC ELSEVIER SCIENCE | 10 |

| 14 | TAYLOR & FRANCIS LTD | 10 |

| 15 | OXFORD UNIV PRESS | 7 |

| 16 | AMER PHYSICAL SOC | 6 |

| 17 | ELSEVIER SCIENCE INC | 6 |

| 18 | IMPACT JOURNALS LLC | 6 |

| 19 | IOP PUBLISHING LTD | 6 |

| 20 | MDPI AG | 6 |

Wileyがトップなのかと思いましたが、Springer、Elsevierは系列会社?で分散しているので、このあたりはまとめて集計したほうがよさそうです。ぱっとSpringer関係が一番投稿数としては多そうですね。

ソースコード

あんまり大したことはしていませんが、分析に利用したソースコードは以下からご覧いただけます。

Jupyter Notebook Viewer

こういう段階的に調査していくときにJupyter notebookはとても便利ですね。いまは環境構築も簡単にAnacondaをインストールするだけでだいたい終了です。Anacondaは以下からダウンロードできます。